"Facial Recognition Is Accurate, if You’re a White Guy(얼굴인식은 정확하다, 만약 당신이 백인 남성이라면 말이다.)" - 2018-02-09 <뉴욕타임스>

얼굴인식 프로그램이 성별, 인종에 따라 다른 인식률을 나타낸다는 연구 결과가 나왔다.

MIT미디어랩 조이 부오라뮈니 연구원과 스탠포드대학 소속 연구원 팀닛 게브루는 기술 알고리즘에 내재된 편견을 찾아내는 '젠더 쉐이드' 프로젝트의 일환으로 IBM, 마이크로소프트, 페이스++ 세 곳의 얼굴 분석 프로그램을 분석한 결과, 성별과 피부색에 따라 인식률이 큰 차이를 보이는 것으로 나타났다고 밝혔다.

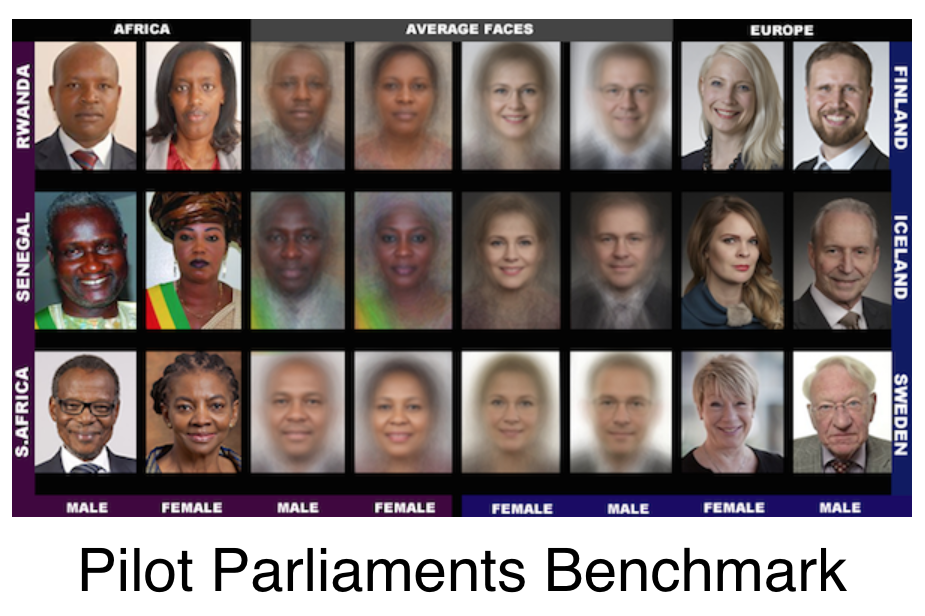

연구원들은 피부과 의사의 조언을 얻어 아프리카 3개국, 유럽 3개국에서 다양한 성별과 피부 유형을 가진 1270명의 대상자를 선정했고 이들의 이미지로 얼굴인식 프로그램의 벤치마크를 제작했다.

IBM, 마이크로소프트, 페이스++ 3곳이 실험 대상으로 선정된 이유는 이들이 만든 얼굴인식 프로그램이 성별 분류 기능을 제공하기 때문이다.

벤치마크 테스트 결과 백인이 흑인보다, 남성이 여성보다 높은 인식률을 보였다. 백인 남성과 흑인 여성 얼굴인식률 차이는 특히 두드러졌다.

IBM, 마이크로소프트, 페이스++ 모두 백인 남성의 얼굴인식률은 각 99.7%, 100%, 99.2%로 오차 범위가 1% 미만에 불과했으나 흑인 여성의 얼굴인식률은 65.3%, 79.2%, 65.5%로 큰 차이를 보였다.

<뉴욕타임스>는 "AI 소프트웨어는 학습에 이용된 데이터만큼 똑똑하다"라며 "다른 연구에 따르면 얼굴인식에 널리 쓰이고 있는 데이터 세트는 남성이 75% 이상, 백인이 80% 이상인 것으로 추산된다"고 말했다. IT매체 <기즈모도>는 "이들 데이터 세트 대부분은 스스로 편향돼 있다"고 지적했다.

데이터 구성에 따라 알고리즘 달라질 수 있어

미국 국립표준기술연구소(NIST)가 2011년 발표한 내용에 따르면 한국, 중국 및 일본에서 개발된 얼굴인식 알고리즘은 백인보다 아시아인에 대한 인식률이 더 높았다. 미국 시사지 <애틀랜틱>은 "알고리즘이 생성되는 조건, 특히 개발팀의 인종 구성과 테스트에 쓰이는 사진의 데이터베이스가 (얼굴인식) 결과의 정확성에 영향을 줄 수 있음을 나타낸다"고 분석했다.

이번 벤치마크 테스트에 대해 IBM은 샘플 선택 편향을 줄이기 위해 노력하고 있다면서 최근 왓슨 시각 인식 API를 변경해 성능을 개선했다고 밝혔다. 마이크로소프트는 "AI 기술의 공정성은 업계에서 중요한 문제이고 마이크로소프트도 매우 중요하게 생각한다"라며 "얼굴인식 기술의 정확성을 높이기 위한 조치를 취했으며 편견을 인식하고 이해하고 제거하는 연구에 지속적으로 투자하고 있다"고 답했다. 페이스++는 이에 대해 아직 답변하지 않았다고 연구원 측은 밝혔다.

https://youtu.be/TWWsW1w-BVo

연구 보고서는 "이 연구는 성별 분류에 초점을 맞췄지만 성별을 결정하는 데 사용된 기계학습 기술은 얼굴 분석 및 자동화 시스템이 쓰이는 수많은 영역에 광범위하게 적용된다"면서 "인구 통계학적 정확성을 공개적으로 테스트하지 않은 얼굴인식 기술이 법 집행 기관 및 공항 등에서 점점 더 많이 사용되고 있다"고 우려를 나타냈다.

조이 부오라뮈니 연구원은 "자동화 시스템은 중립적이지 않다. 인공지능 (시스템)을 형성할 힘을 가지고 있는 이들의 우선순위, 선호도 및 편견을 반영한다"고 지적했다.

<뉴욕타임스>는 "이러한 서로 다른 결과는 현실 세계의 편견이 얼굴인식 컴퓨터 시스템의 인공지능에 어떻게 스며드는지 보여준다"고 전했다.